昇思MindSpore2024年技术帖分享大会圆满结束!全年收获80+高质量技术帖, 2025年全新升级,推出“2025年昇思干货小卖部,你投我就收!”,活动继续每月征集技术帖。本期技术文章由社区开发者yide12输出并投稿。如果您对活动感兴趣,欢迎在昇思论坛投稿。

01 概述

优化器是深度学习框架中负责参数更新的核心组件,其作用是根据损失函数的梯度信息调整模型参数,使模型性能逐步优化。MindSpore优化器系统采用分层架构设计,提供了高效、灵活的参数优化解决方案。

02 架构设计

MindSpore优化器采用四层架构设计:

用户接口层: 提供统一的API接口,屏蔽底层实现复杂性

optimizer = nn.Adam(params=net.trainable_params(), learning_rate=0.001)

优化器基类层: 定义通用的优化器行为和接口规范

- 参数管理和验证

- 学习率调度机制

- 梯度预处理流水线

算法实现层:实现具体的优化算法逻辑

- Adam、SGD、AdamW等算法实现

- 算法变体支持(Lazy Adam、Adam Offload等)

底层执行层:负责实际的数值计算和硬件适配

- 算子融合优化

- 多硬件平台支持

2.2 核心组件

参数管理器: 负责参数分组、权重衰减策略配置

学习率调度器: 支持固定、动态、自适应学习率策略

梯度处理器: 实现梯度预处理、缩放、稀疏处理等功能

03 Adam优化器实现原理

3.1 算法基础

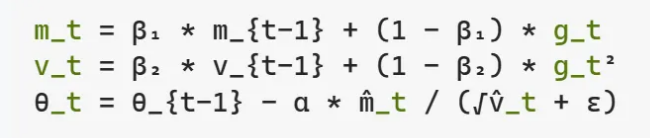

Adam(Adaptive Moment Estimation)算法结合了动量法和自适应学习率的优势,维护两个指数移动平均:

- 一阶矩估计(m): 梯度的指数移动平均

- 二阶矩估计(v): 梯度平方的指数移动平均

数学表达式:

其中 m̂_t 和 v̂_t 是偏差修正后的矩估计。

3.2 执行流程分析

Adam优化器的执行流程包含以下关键步骤:

步骤1:梯度预处理

def construct(self, gradients):

# 梯度扁平化处理

gradients = self.flatten_gradients(gradients)

# 权重衰减应用

gradients = self.decay_weight(gradients)

# 梯度中心化(提升训练稳定性)

gradients = self.gradients_centralization(gradients)

# 梯度缩放(混合精度训练支持)

gradients = self.scale_grad(gradients)

# 稀疏梯度索引去重

gradients = self._grad_sparse_indices_deduplicate(gradients)

步骤2:学习率获取 与步数更新

# 获取当前学习率(支持动态调度)

lr = self.get_lr()

# 全局步数递增

self.assignadd(self.global_step, self.global_step_increase_tensor)

步骤3:Beta幂次更新

# 更新beta1和beta2的幂次,用于偏差修正

beta1_power = self.beta1_power * self.beta1

beta2_power = self.beta2_power * self.beta2

步骤4:参数更新执行

return self._apply_adam(params, beta1_power, beta2_power,

moment1, moment2, lr, gradients)

04 Adam算法变体

4.1 AdamWeightDecay

AdamWeightDecay将权重衰减直接集成到参数更新过程中,相比传统的L2正则化方法,提供了更精确的正则化效果。

AdamWeightDecay的核心特点在于其融合优化策略:

融合优化器路径: 当use_fused_opt=True时,使用底层融合算子_fused_adam_weight_decay,实现单一算子内完成梯度处理、权重衰减和参数更新的全流程。

参数分组支持: 通过is_group和is_group_lr标志,支持不同参数组使用不同的学习率和权重衰减策略。

4.2 AdamOffload

AdamOffload实现了计算卸载机制,将优化器计算转移到CPU执行,以减少GPU内存占用:

内存优化策略:

- 参数保持在设备端(GPU/NPU)

- 优化器状态(动量)存储在主机端(CPU)

- 梯度在设备和主机间传输

适用场景:

- 大模型训练时GPU内存不足

- 需要在有限硬件资源下训练更大规模模型

05 性能优化技术

5.1 算子融合

MindSpore通过算子融合技术将多个独立的数学运算合并为单一算子,减少内存访问开销:

# 传统方式:多个独立算子

moment1 = beta1 * moment1 + (1 - beta1) * grad

moment2 = beta2 * moment2 + (1 - beta2) * grad * grad

param = param - lr * moment1 / (sqrt(moment2) + eps)

# 融合方式:单一算子完成全部计算

fused_adam_op(param, moment1, moment2, grad, lr, beta1, beta2, eps)

5.2 内存管理优化

原地更新(In-place Update):

- 直接在原参数内存位置进行更新,避免额外内存分配

- 减少内存碎片和垃圾回收开销

内存池机制:

- 预分配固定大小的内存池

- 动态分配和回收内存块

- 减少频繁的内存申请和释放操作

5.3 并行优化

数据并行:

if self.use_parallel:

self.broadcast_params(optim_result)

通过参数广播机制确保多设备间参数同步,支持大规模分布式训练。

06 学习率调度机制

MindSpore提供了灵活的学习率调度框架:

动态学习率获取:

lr = self.get_lr() # 支持标量、张量和调度器

调度策略类型:

- 恒定学习率:固定数值

- 分段常数:不同训练阶段使用不同学习率

- 指数衰减:按指数函数递减

- 余弦退火:按余弦函数变化

07 工程实践要点

7.1 参数分组策略

# 不同层使用不同优化参数

conv_params = [p for p in params if 'conv' in p.name]

fc_params = [p for p in params if 'fc' in p.name]

optimizer = nn.Adam([

{'params': conv_params, 'lr': 1e-4, 'weight_decay': 1e-4},

{'params': fc_params, 'lr': 1e-3, 'weight_decay': 1e-5}

])

7.2 梯度处理机制

原地更新(In-place Update):

- 梯度裁剪: 防止梯度爆炸

- 梯度累积: 支持大批次训练

- 稀疏梯度优化: 针对嵌入层等稀疏参数的特殊处理

7.3 数值稳定性保障

- 混合精度支持: FP16计算,FP32累积

- 溢出检测: 自动检测和处理数值溢出

- 偏差修正: Adam算法的beta幂次修正机制

08 总结

MindSpore优化器实现体现了现代深度学习框架的工程化水准:

- 架构设计: 分层抽象,职责清晰,易于扩展

- 算法实现: 数学严谨,数值稳定,性能优化

- 工程实践: 内存高效,并行友好,易于使用

这种设计使得MindSpore能够在保证算法正确性的前提下,实现高性能的大规模深度学习训练。