DeepSeek-R1-Distill-Qwen-1.5B 在昇腾开发板上的 LoRA 微调

LoRA(Low-Rank Adaptation)是一种只训练旁支小矩阵的参数高效微调方法。

核心原理:冻结原模型全部权重,仅在 Attention 的 QKV 投影层插入低秩矩阵 A、B(秩 r 通常 8~64)。

优势:1.5B 基座模型 3 GB 权重 → 仅需额外 6~8 MB 可训练参数,显存占用小,香橙派内存无压力。

实践流程:

(1) 环境配置二次确认

(2)甄嬛传数据集下载及处理

(3)实例化base mode

(4)LoRA配置

(5)实例化LoRA模型和获取权重

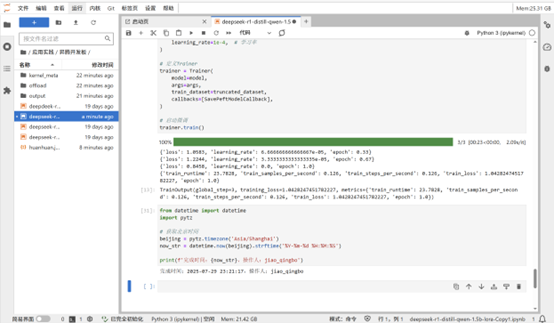

(6)训练超参和定义Trainer

(7)启动微调

最终做到了把“甄嬛”塞进香橙派里