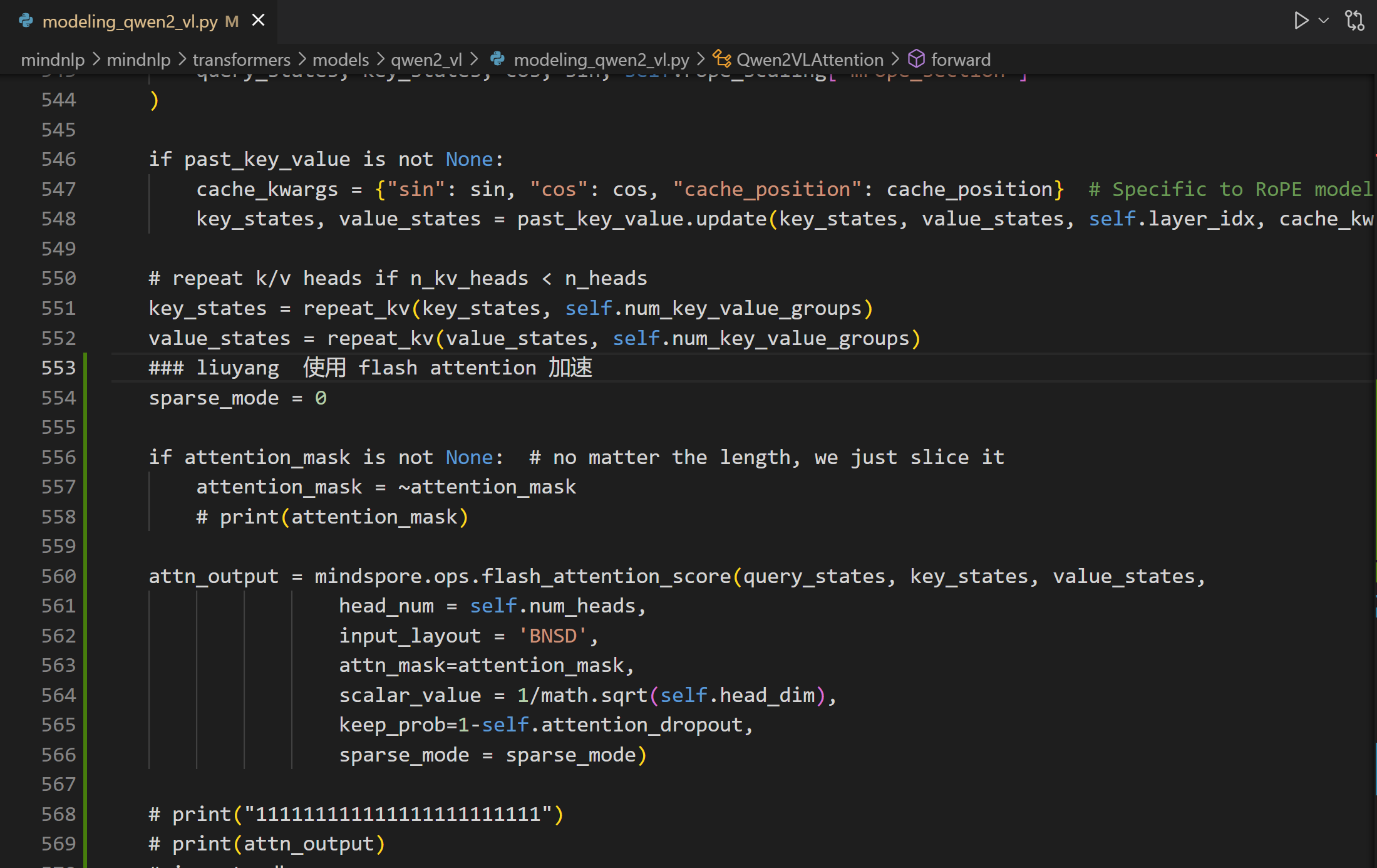

基于mindnlp仓库0.4分支,在对qwen2_vl进行加速时,使用mindspore.ops.flash_attention_score算子代替常规attention,发现得到的输出attn_output和原始版本输出不一致,实现代码如下图:

用户您好,欢迎使用MindSpore,已经收到您上述的问题,还请耐心等待下答复~

@kindredspirit 用户您好,MindSpore支撑人已经分析并给出了问题的原因,由于较长时间未看到您采纳回答,这里版主将进行采纳回答的结帖操作,如果还其他疑问请发新帖子提问,谢谢支持~

此话题已在最后回复的 60 分钟后被自动关闭。不再允许新回复。