Lora原理

LoRA(Low-Rank Adaptation)是一种参数高效微调(Parameter-Efficient Fine-Tuning, PEFT)方法。

其核心思想是冻结原始网络参数,对Attention层中QKV等模块添加旁支。旁支包含两个低维度的矩阵A和矩阵B,微调过程中仅更新A、B 矩阵。通过这种方式,显著降低计算和内存成本,同时达到与全参数微调相近的性能。

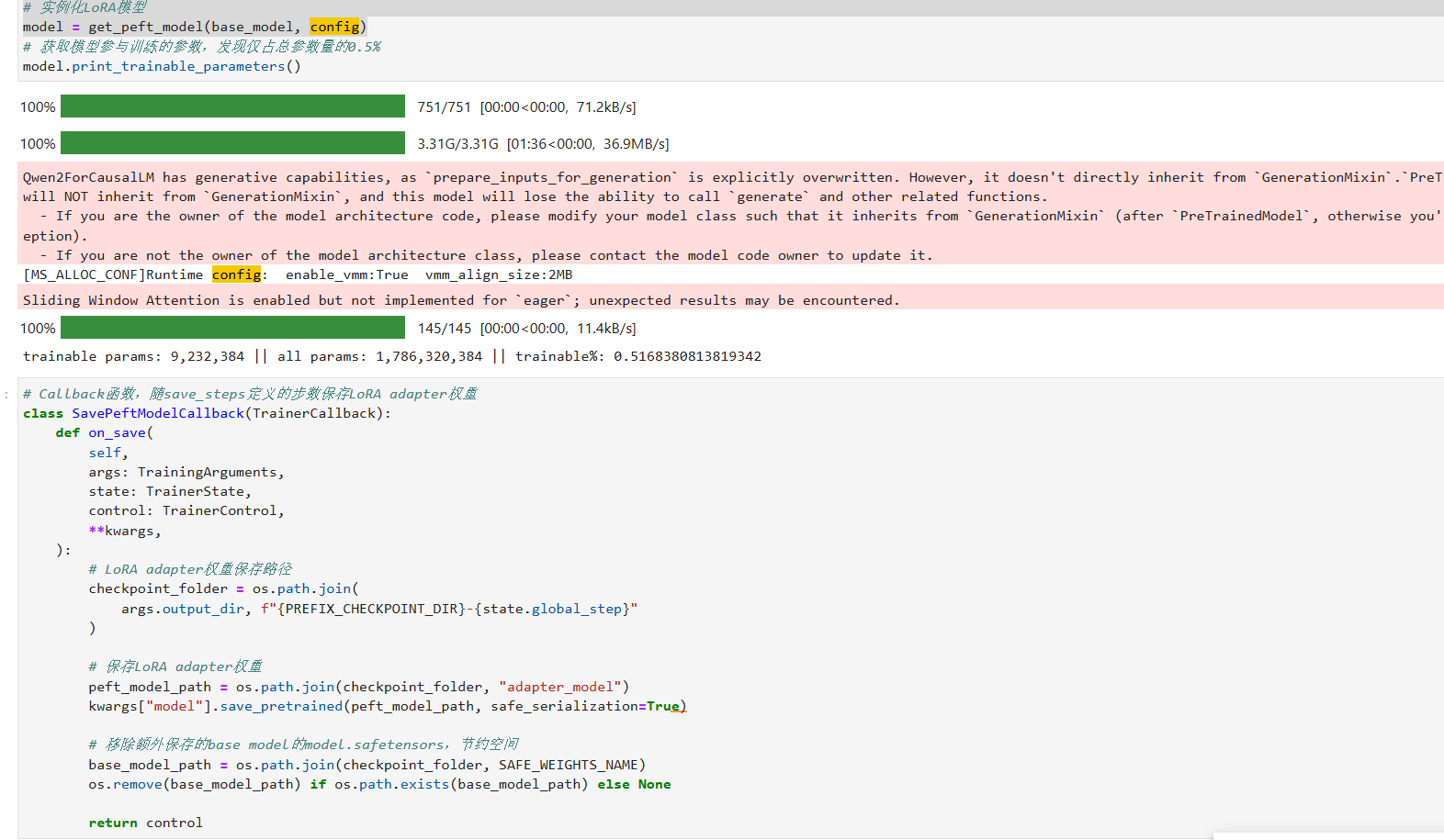

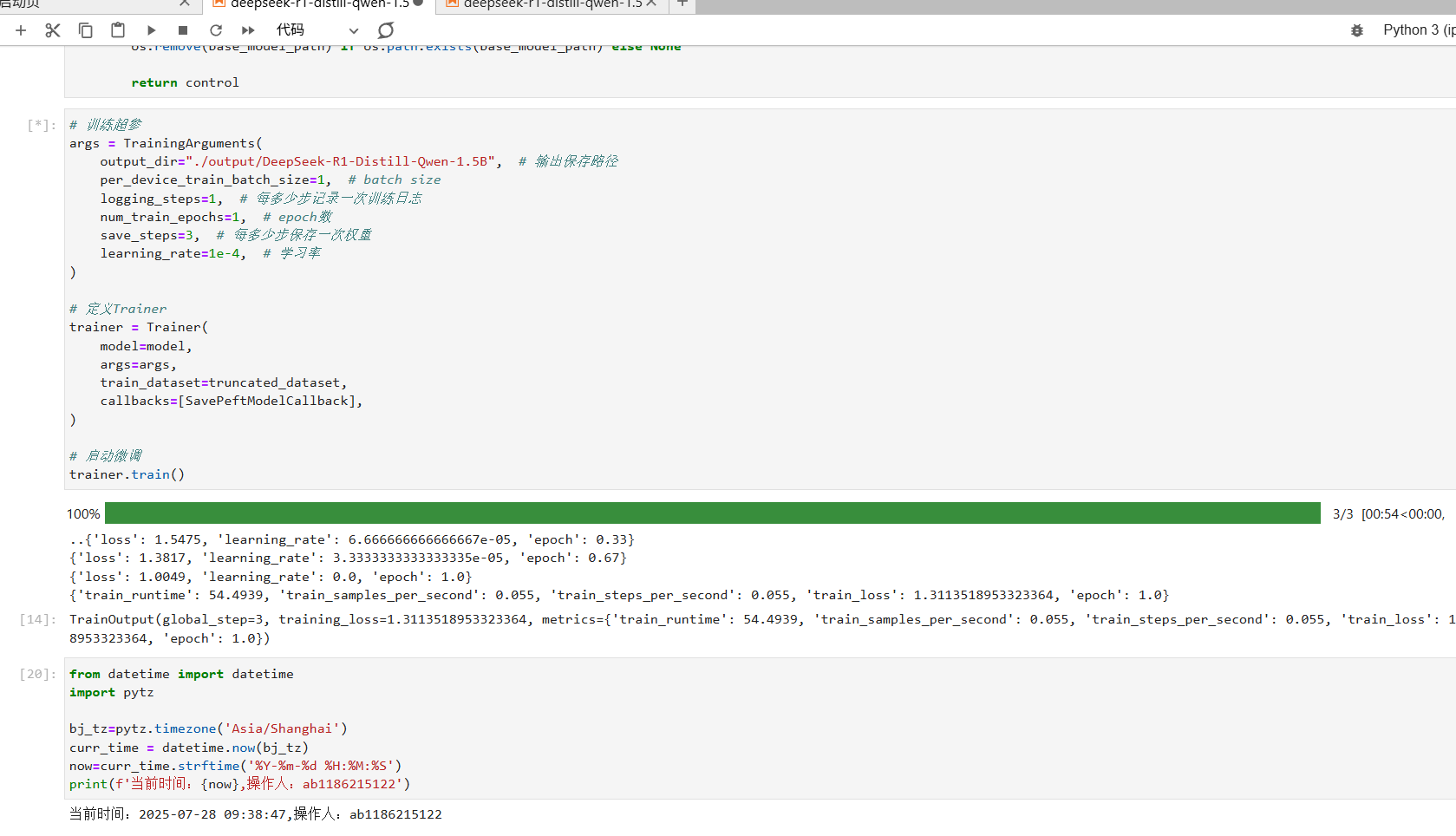

在我们这一次实验就用到了Lora微调。顺着教程执行下来, 可以微调成功。而且占用的参数量竟然才是总参数量的0.5%。这对于小硬件设施是比较良好的。