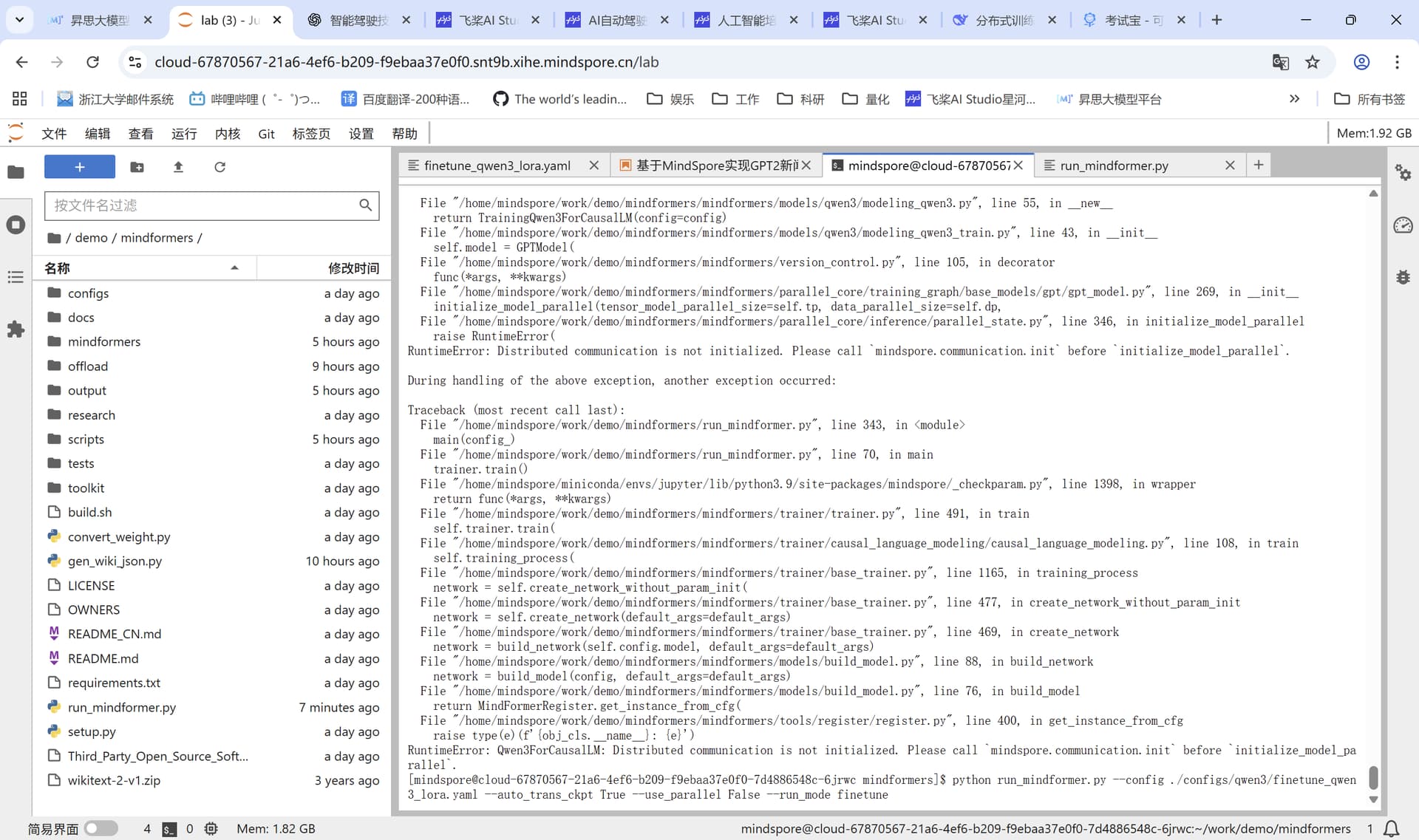

我是单卡单机跑模型的训练和微调,use_parallel设置成False而且各种并行都设成了1,但总是报Distributed communication is not initialized,到底是什么问题?

这个问题我们在解决中,目前可以通过如下命令尝试拉起任务

msrun --bind_core=True --worker_num=1 --local_worker_num=1 --master_port=7118 --log_dir=output/msrun_log --join=True --cluster_time_out=300 run_mindformer.py --config "${CONFIG}"

用户您好,MindSpore支撑人已经分析并给出了问题的原因,由于较长时间未看到您采纳回答,这里版主将进行采纳回答的结帖操作,如果还其他疑问请发新帖子提问,谢谢支持~

此话题已在最后回复的 60 分钟后被自动关闭。不再允许新回复。